Los investigadores de ciberseguridad han descubierto que los complementos de terceros disponibles para OpenAI ChatGPT podrían actuar como una nueva superficie de ataque para los actores de amenazas que buscan obtener acceso no autorizado a datos confidenciales.

Según una nueva investigación publicada por Salt Labs, las fallas de seguridad encontradas directamente en ChatGPT y dentro del ecosistema podrían permitir a los atacantes instalar complementos maliciosos sin el consentimiento de los usuarios y secuestrar cuentas en sitios web de terceros como GitHub.

Los complementos de ChatGPT , como su nombre lo indica, son herramientas diseñadas para ejecutarse sobre el modelo de lenguaje grande (LLM) con el objetivo de acceder a información actualizada, ejecutar cálculos o acceder a servicios de terceros.

Desde entonces, OpenAI también ha introducido GPT , que son versiones personalizadas de ChatGPT diseñadas para casos de uso específicos, al tiempo que reducen las dependencias de servicios de terceros. A partir del 19 de marzo de 2024, los usuarios de ChatGPT ya no podrán instalar nuevos complementos ni crear nuevas conversaciones con complementos existentes.

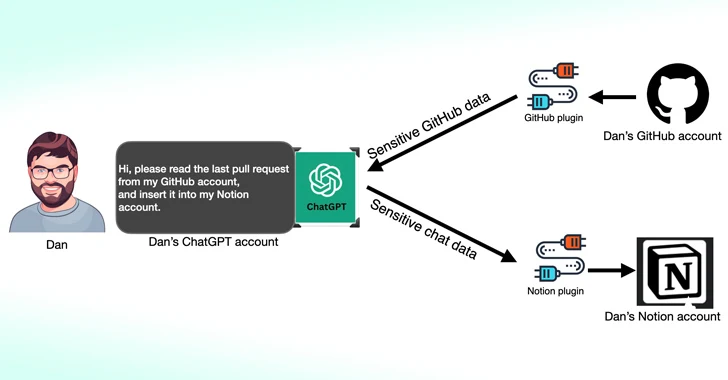

Una de las fallas descubiertas por Salt Labs implica explotar el flujo de trabajo de OAuth para engañar a un usuario para que instale un complemento arbitrario aprovechando el hecho de que ChatGPT no valida que el usuario realmente inició la instalación del complemento.

Esto efectivamente podría permitir que los actores de amenazas intercepten y exfiltren todos los datos compartidos por la víctima, que pueden contener información patentada.

Los investigadores de ciberseguridad han descubierto que los complementos de terceros disponibles para OpenAI ChatGPT podrían actuar como una nueva superficie de ataque para los actores de amenazas que buscan obtener acceso no autorizado a datos confidenciales.

Según una nueva investigación publicada por Salt Labs, las fallas de seguridad encontradas directamente en ChatGPT y dentro del ecosistema podrían permitir a los atacantes instalar complementos maliciosos sin el consentimiento de los usuarios y secuestrar cuentas en sitios web de terceros como GitHub.

Los complementos de ChatGPT , como su nombre lo indica, son herramientas diseñadas para ejecutarse sobre el modelo de lenguaje grande (LLM) con el objetivo de acceder a información actualizada, ejecutar cálculos o acceder a servicios de terceros.

Desde entonces, OpenAI también ha introducido GPT , que son versiones personalizadas de ChatGPT diseñadas para casos de uso específicos, al tiempo que reducen las dependencias de servicios de terceros. A partir del 19 de marzo de 2024, los usuarios de ChatGPT ya no podrán instalar nuevos complementos ni crear nuevas conversaciones con complementos existentes.

Una de las fallas descubiertas por Salt Labs implica explotar el flujo de trabajo de OAuth para engañar a un usuario para que instale un complemento arbitrario aprovechando el hecho de que ChatGPT no valida que el usuario realmente inició la instalación del complemento.

Esto efectivamente podría permitir que los actores de amenazas intercepten y exfiltren todos los datos compartidos por la víctima, que pueden contener información patentada.

La firma de ciberseguridad también descubrió problemas con PluginLab que los actores de amenazas podrían utilizar como arma para llevar a cabo ataques de apropiación de cuentas sin hacer clic, permitiéndoles obtener el control de la cuenta de una organización en sitios web de terceros como GitHub y acceder a sus repositorios de código fuente.

«‘auth.pluginlab[.]ai/oauth/authorized’ no autentica la solicitud, lo que significa que el atacante puede insertar otro ID de miembro (también conocido como la víctima) y obtener un código que represente a la víctima», explicó el investigador de seguridad Aviad Carmel. «Con ese código, puede usar ChatGPT y acceder al GitHub de la víctima».

El ID de miembro de la víctima se puede obtener consultando el punto final «auth.pluginlab[.]ai/members/requestMagicEmailCode». No hay evidencia de que los datos del usuario se hayan visto comprometidos debido a la falla.

También se descubre en varios complementos, incluido Kesem AI, un error de manipulación de la redirección de OAuth que podría permitir a un atacante robar las credenciales de la cuenta asociadas con el complemento enviando un enlace especialmente diseñado a la víctima.

El desarrollo se produce semanas después de que Imperva detallara dos vulnerabilidades de secuencias de comandos entre sitios (XSS) en ChatGPT que podrían encadenarse para tomar el control de cualquier cuenta.

En diciembre de 2023, el investigador de seguridad Johann Rehberger demostró cómo los actores malintencionados podrían crear GPT personalizados que pueden realizar phishing para obtener credenciales de usuario y transmitir los datos robados a un servidor externo.

Nuevo ataque de registro de teclas remoto a asistentes de IA

Los hallazgos también siguen a una nueva investigación publicada esta semana sobre un ataque de canal lateral LLM que emplea la longitud del token como medio encubierto para extraer respuestas cifradas de los asistentes de IA a través de la web.

«Los LLM generan y envían respuestas como una serie de tokens (similares a palabras), y cada token se transmite desde el servidor al usuario a medida que se genera», dijo un grupo de académicos de la Universidad Ben-Gurion y el Laboratorio de Investigación de IA Ofensiva.

«Si bien este proceso está cifrado, la transmisión secuencial de tokens expone un nuevo canal lateral: el canal lateral de longitud de token. A pesar del cifrado, el tamaño de los paquetes puede revelar la longitud de los tokens, lo que potencialmente permite a los atacantes en la red inferir información sensible y confidencial compartida en conversaciones privadas de asistentes de IA».

Esto se logra mediante un ataque de inferencia de tokens diseñado para descifrar respuestas en tráfico cifrado mediante el entrenamiento de un modelo LLM capaz de traducir secuencias de longitud de tokens a sus contrapartes oracionales en lenguaje natural (es decir, texto sin formato).

En otras palabras, la idea central es interceptar las respuestas del chat en tiempo real con un proveedor de LLM, utilizar los encabezados de los paquetes de red para inferir la longitud de cada token, extraer y analizar segmentos de texto y aprovechar el LLM personalizado para inferir la respuesta.

Dos requisitos previos clave para llevar a cabo el ataque son un cliente de chat de IA que se ejecute en modo de transmisión y un adversario que sea capaz de capturar el tráfico de red entre el cliente y el chatbot de IA.

Para contrarrestar la eficacia del ataque de canal lateral, se recomienda que las empresas que desarrollan asistentes de IA apliquen relleno aleatorio para ocultar la longitud real de los tokens, transmitan los tokens en grupos más grandes en lugar de individualmente, y envíen respuestas completas de una vez, en lugar de en un moda ficha por ficha.

«Equilibrar la seguridad con la usabilidad y el rendimiento presenta un desafío complejo que requiere una consideración cuidadosa», concluyeron los investigadores.

Fuente y redacción: thehackernews.com