Apodado ‘ Light Commands ‘, el truco se basa en una vulnerabilidad en los micrófonos MEMS integrados en sistemas populares controlados por voz ampliamente utilizados que responden involuntariamente a la luz como si fuera sonido.

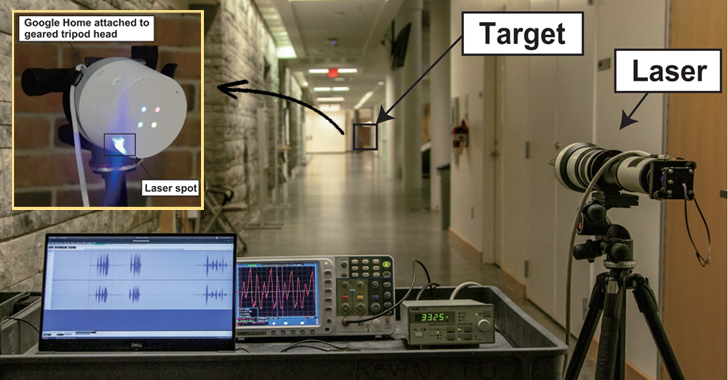

Según los experimentos realizados por un equipo de investigadores de las universidades japonesa y de Michigan, un atacante remoto que se encuentre a una distancia de varios metros de un dispositivo puede disparar el ataque de manera encubierta simplemente modulando la amplitud de la luz láser para producir una onda de presión acústica.

«Al modular una señal eléctrica en la intensidad de un haz de luz, los atacantes pueden engañar a los micrófonos para que produzcan señales eléctricas como si estuvieran recibiendo audio genuino», dijeron los investigadores en su documento.

¿No suena esto espeluznante? Ahora lea esta parte detenidamente …

Los asistentes de voz inteligentes en sus teléfonos, tabletas y otros dispositivos inteligentes, como Google Home y Nest Cam IQ, Amazon Alexa y Echo, Portal de Facebook, dispositivos Apple Siri, son todos vulnerables a este nuevo dispositivo basado en la luz. ataque de inyección de señal.

«Como tal, cualquier sistema que use micrófonos MEMS y actúe sobre estos datos sin la confirmación adicional del usuario podría ser vulnerable», dijeron los investigadores.

Dado que la técnica finalmente permite a los atacantes inyectar comandos como un usuario legítimo, el impacto de dicho ataque se puede evaluar en función del nivel de acceso que tienen sus asistentes de voz sobre otros dispositivos o servicios conectados.

Por lo tanto, con el ataque de comandos ligeros, los atacantes también pueden secuestrar cualquier sistema inteligente digital conectado a los asistentes controlados por voz, por ejemplo:

- Controla los interruptores inteligentes del hogar,

- Abra puertas de garaje inteligentes,

- Hacer compras en línea,

- Desbloquee y arranque ciertos vehículos de forma remota,

- Abra cerraduras inteligentes forzando sigilosamente el número PIN del usuario.

Como se muestra en la demostración de video que se enumera a continuación: En uno de sus experimentos, los investigadores simplemente inyectaron el comando «OK Google, abre la puerta del garaje» a un Google Home disparando un rayo láser en Google Home que estaba conectado a él y abrió con éxito un garaje puerta.

En un segundo experimento, los investigadores emitieron con éxito el mismo comando, pero esta vez desde un edificio separado, a unos 230 pies del dispositivo de Google Home a través de una ventana de vidrio.

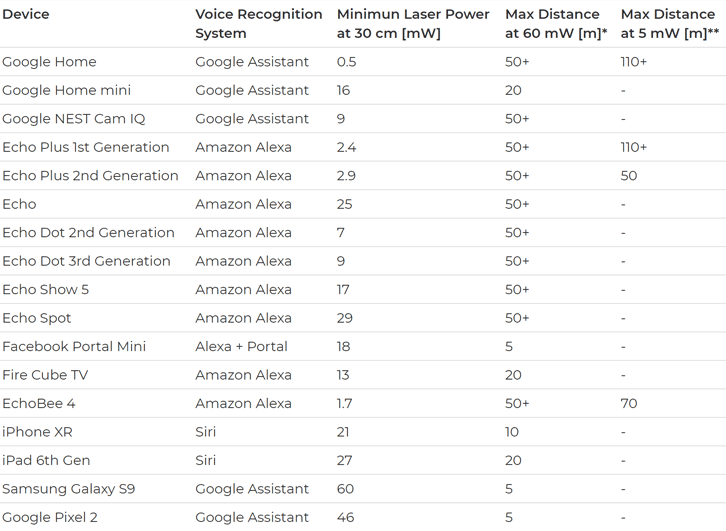

Además de los dispositivos de mayor alcance, los investigadores también pudieron probar sus ataques contra una variedad de dispositivos de teléfonos inteligentes que usan asistentes de voz, incluidos iPhone XR, Samsung Galaxy S9 y Google Pixel 2, pero solo funcionan a distancias cortas.

El alcance máximo para este ataque depende de la potencia del láser, la intensidad de la luz y, por supuesto, sus capacidades de puntería. Además de esto, las barreras físicas (por ejemplo, ventanas) y la absorción de ondas ultrasónicas en el aire pueden reducir aún más el alcance del ataque.

Además, en los casos en que el reconocimiento de voz está habilitado, los atacantes pueden vencer la función de autenticación del hablante construyendo la grabación de los comandos de voz deseados a partir de las palabras relevantes pronunciadas por el propietario legítimo del dispositivo.

Según los investigadores, estos ataques se pueden montar «fácil y económicamente», utilizando un puntero láser simple (menos de $ 20), un controlador láser ($ 339) y un amplificador de sonido ($ 28). Para su configuración, también usaron un teleobjetivo ($ 199.95) para enfocar el láser para ataques de largo alcance.

¿Cómo puede protegerse contra la vulnerabilidad de la luz en la vida real? Los fabricantes de software deberían ofrecer a los usuarios agregar una capa adicional de autenticación antes de procesar comandos para mitigar los ataques maliciosos.

Por ahora, la solución mejor y común es mantener la línea de visión de sus dispositivos de asistente de voz bloqueada físicamente desde el exterior y evitar darle acceso a cosas a las que no desea que otra persona acceda.

El equipo de investigadores, Takeshi Sugawara de la Universidad de Electrocomunicación de Japón y el Sr. Fu, Daniel Genkin, Sara Rampazzi y Benjamin Cyr de la Universidad de Michigan, también publicaron sus hallazgos en un documento [ PDF ] el lunes.

Genkin también fue uno de los investigadores que descubrió dos vulnerabilidades principales de microprocesador, conocidas como Meltdown y Spectre , el año pasado.

Fuente: thehackernews.com