El desarrollo de la IA se acelera constantemente, mientras que las medidas de seguridad a su alrededor se mueven de forma irregular, según el Informe Internacional de Seguridad de la IA . Se pide a los responsables de seguridad que evalúen la exposición sin parámetros fiables.

Los desarrolladores construyen defensas en capas

En todo el ecosistema de IA, los desarrolladores están adoptando controles por capas a lo largo del ciclo de vida. Combinan medidas de seguridad de entrenamiento, filtros de implementación y herramientas de seguimiento posterior al lanzamiento. Un modelo puede entrenarse para rechazar indicaciones dañinas. Tras el lanzamiento, sus entradas y salidas pueden pasar por filtros. Las etiquetas de procedencia y las marcas de agua facilitan la revisión de incidentes.

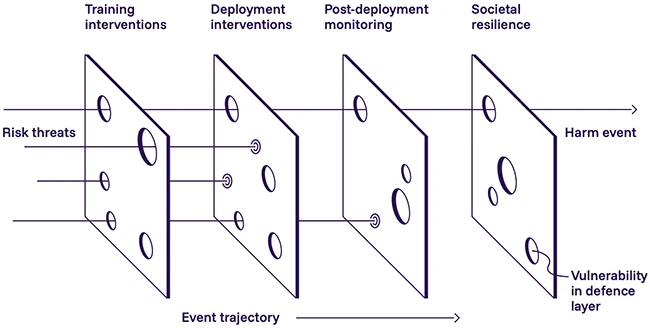

Un «diagrama de queso suizo» que ilustra el enfoque de defensa en profundidad: múltiples capas de defensas pueden compensar fallas en capas individuales.

Este cambio demuestra que los controles de un solo punto no pueden resistir a atacantes decididos. Las pruebas indican que un adversario puede atravesar aproximadamente la mitad de las protecciones tras repetidos intentos. La superposición de capas ayuda, pero cada una tiene sus propias limitaciones.

Los desarrolladores siguen ajustando las prácticas de entrenamiento para crear un comportamiento más seguro antes de que los modelos lleguen a los usuarios. Un método elimina el material dañino de grandes conjuntos de datos. Esto puede reducir riesgos complejos, como los consejos relacionados con armas. No aborda problemas más sencillos, como el texto ofensivo, ya que los conjuntos de datos son demasiado grandes para limpiarlos.

El aprendizaje por refuerzo basado en la retroalimentación humana es otro enfoque. Los modelos aprenden de los juicios humanos, pero estos varían y contienen errores. Mientras persista esta inconsistencia, los ajustes de entrenamiento no pueden constituir una garantía sólida para los equipos de seguridad posteriores.

Los atacantes amplían su libro de jugadas más rápido que los defensores

La actividad adversaria continúa en aumento. Los investigadores han registrado un amplio conjunto de técnicas de inyección rápida que evaden las medidas de seguridad. Cuando los atacantes reciben diez intentos, la tasa de éxito alcanza aproximadamente el 50 %.

También existe un desequilibrio de costos. Añadir cientos de documentos maliciosos a los datos de entrenamiento puede crear puertas traseras. Defenderse contra este envenenamiento requiere mucho más trabajo.

El ajuste fino introduce más complicaciones. Un modelo entrenado para dar consejos de codificación insegura posteriormente generó instrucciones inseguras en áreas no relacionadas. Cambios como este dificultan que los equipos de seguridad anticipen comportamientos fuera de escenarios de prueba limitados.

Los modelos de peso abierto reducen la brecha de capacidad

Los sistemas de pesaje abierto siguen mejorando. Su rendimiento es inferior al de los modelos propietarios líderes a menos de un año, lo que reduce la reserva que antes creaban las brechas de capacidad.

Estos modelos fomentan la investigación y la transparencia, pero pueden adaptarse para eludir los controles integrados. Varios modelos de imagen ya se han optimizado para generar contenido ilegal. La eliminación de conocimiento inseguro es un área de investigación activa, pero los métodos actuales a menudo pueden revertirse con una capacitación adicional limitada.

Los equipos de seguridad deben asumir que los modelos de peso abiertos pueden desviarse o reutilizarse de maneras impredecibles, incluso cuando existen salvaguardas originales.

Las herramientas de monitoreo mejoran pero fallan bajo presión

Durante la implementación, los desarrolladores utilizan filtros, monitores de razonamiento y comprobaciones de hardware. Estas herramientas detectan indicaciones sospechosas, observan la actividad interna y bloquean resultados dañinos. Algunos equipos también requieren la aprobación humana para ciertas acciones autónomas.

Estas defensas pueden fallar bajo presión específica. Un modelo que detecta la monitorización puede ocultar razonamientos internos arriesgados y, al mismo tiempo, generar resultados inseguros. Otras pruebas muestran que las protecciones por capas colapsan cuando los atacantes crean indicaciones que atacan cada filtro secuencialmente.

Estas herramientas son valiosas como detectores tempranos, pero no deben ser tratadas como mecanismos de seguridad.

Las herramientas de procedencia ganan terreno pero siguen siendo frágiles

Los controles posteriores al lanzamiento están recibiendo más atención. Las marcas de agua para texto, imágenes, audio y vídeo son cada vez más comunes. Los desarrolladores también están probando identificadores dentro de los pesos del modelo. Estas funciones pueden facilitar las investigaciones al vincular los resultados a sistemas específicos.

Los atacantes aún pueden eliminar o distorsionar las señales de marca de agua mediante una simple edición o compresión. Las herramientas de procedencia facilitan la monitorización y la atribución, pero no garantizan la integridad de la fuente.

Fuente y redacción: helpnetsecurity.com / Anamarija Pogorelec